機械翻訳について

こんにちは。開発部の橋村です。

最近 chatGPTやBardといった、対話的AIが話題になっていますが、

今日は古くて新しい話題、機械翻訳についてちょっとだけ。

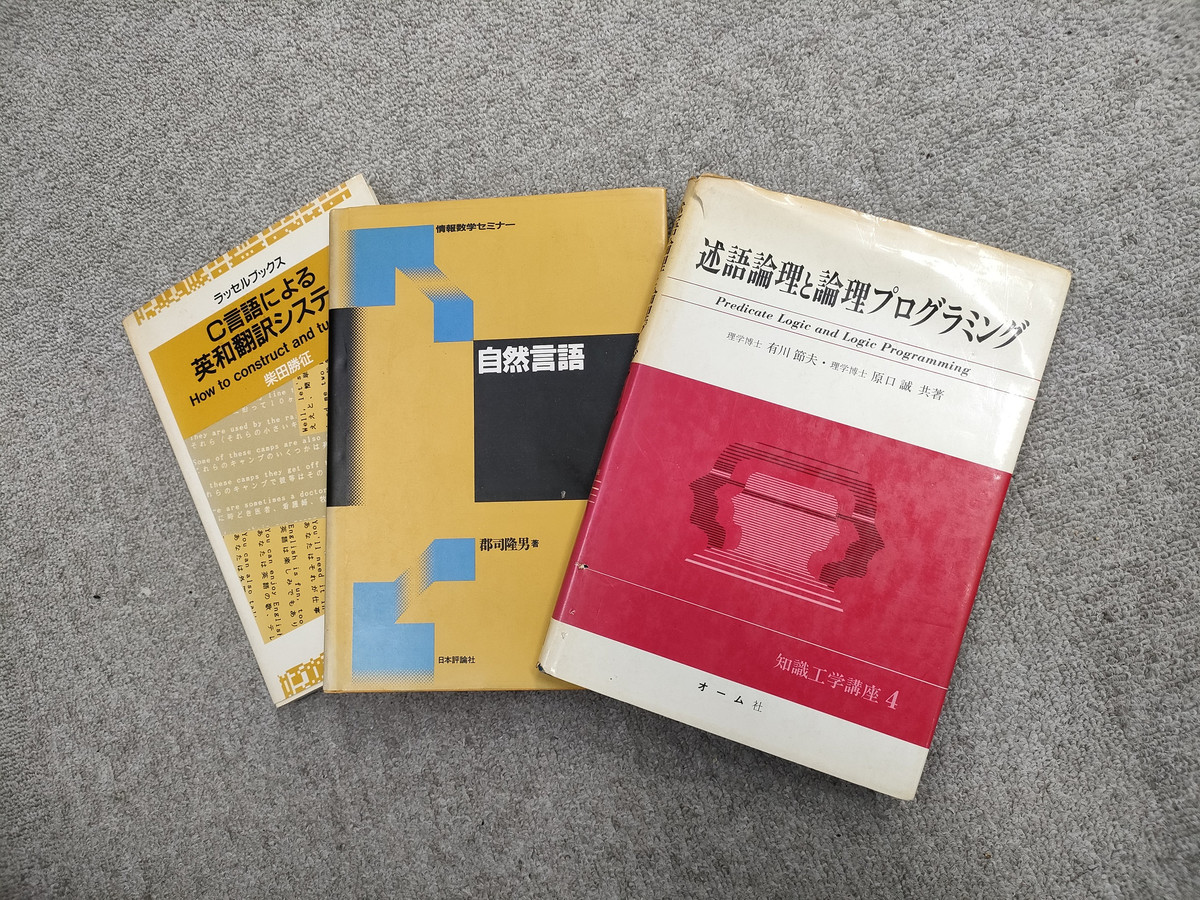

今から30年ほど前、コンピュータによる翻訳は

構文解析によって文章の「意味」をデータ化して、

それを別の言語に変換する、というアプローチでした。

当時、C言語を覚えたてだった私も一所懸命トライした記憶があります。

なんというか、多分に哲学的なこの方法は、話し言葉や流行語、略語、古語、方言などなど、

イレギュラーな入力に非常に弱く、つまるところ、使われる言語の全てのシーンにおいて

共通するルールを予めプログラムに組み込まないと、期待したように動かない、という気が遠くなるような仕組みでした。

同義語辞書や文法のルールを組み込むことで、なんとか組み合わせの数を減らすことはできないか・・・と

足掻いた挙げ句、ギブアップしました。

大きく事情が変わったのは、AIやビッグデータが注目されてから、

特に、ぐっと翻訳の精度が上がったのは、ここ5~6年のことではないかと思います。

入力された文章を解析する部分は大きな変更はないのですが、

「翻訳」のコア部分に機械学習を導入することによって、

統計的に確率が高い訳語を充てる、という

アプローチを導入できるようになりました。

蓄積したデータや学習パターンが、ある一定のレベルを超えると、

突然それらしい(使い物になる)訳文を吐きはじめるようです。

今もあきれるほど沢山の実例とフィードバックによって、

日々更新が行われています。

実際に使われている言葉をもとに統計処理している関係か、

よく出現する言葉、たとえば流行語やテクニカルタームの

翻訳について、従前と比べて非常に高い精度が実現されています。

私は30年前に挫折した時点で諦めたクチなのですが、

もしかするとどこかに、A案でダメならB案で、それでダメならAB複合案で・・・と

執念を燃やし続けていた技術者さんがいたのかもしれません。

お陰様で、まだ日本語訳が出ていない英語の技術書(原書)も、

原著のPDFを機械翻訳にかけることで、随分内容を把握しやすくなりました。

以前であれば、英和辞典を引きながら、ちまちま自家製の訳文を作っていたところです。

大きな感謝と敬意を捧げつつ、有り難く使わせて頂いています。

私も、もうちょっとだけ諦め悪くなろうかな、と思った次第でした。